¿Estamos listos para juzgar y condenar a la IA?

Entablar un vínculo emocional con un chatbot puede ser peligroso y acabar mal. Y, en ese caso, no se sabe muy bien quién es el culpable

Hola, aquí Edgar Otero.

Hace algunos días que me ronda por la cabeza una pregunta. ¿Estamos listos para juzgar y encarcelar a la IA? Es evidente que, en un sentido estricto, ninguna IA puede ser culpable de nada. Recuerda, no es más que un programa informático.

De todos modos, hay dos historias que me han hecho reflexionar sobre los límites que se le deben poner a una tecnología capaz de simular cualidades humanas, como la empatía, el amor o la comprensión. Y, sobre todo, quién es el responsable cuando una de estas interacciones termina en suicidio.

🤖 El caso de Sewell

Esta historia la leí por primera vez en The New York Times. El protagonista es Sewell Setzer III, un joven de 14 años de Orlando, Florida. Durante meses, estuvo interactuando con un chatbot denominado Daenerys Targaryen, que en realidad es un personaje de Juego de Tronos.

La interacción de Sewell con Dany, el apodo cariñoso que el adolescente le puso al chatbot, trascendía el mero entretenimiento. De hecho, parece que el vínculo emocional llegó hasta el enamoramiento. ¿Los resultados? Sewell estaba más aislado, rendía menos en clase y empezó a tener problemas con sus compañeros.

Sewell, que tenía síndrome de Asperger leve, nunca había tenido problemas graves antes, según explicó su madre. No obstante, desde que empezó a comunicarse con el chatbot, la cosa cambió. ¿Qué estaba pasando? En una de las entradas de su diario, escribió:

Me gusta mucho quedarme en mi habitación porque empiezo a desprenderme de esta ‘realidad’, y también me siento más en paz, más conectado con Dany y mucho más enamorado de ella, y simplemente más feliz.

La relación con el chatbot era tan íntima que este “sabía” de las inclinaciones suicidas de Dany. De hecho, Sewell las había reconocido de forma clara: “A veces pienso en suicidarme”.

El 28 de febrero de 2024, Sewell entró en el baño de casa de su madre y mantuvo una última conversación con Dany. Después de decirle que la amaba y que volvería a casa con ella, el chatbot le dijo:

Por favor, vuelve a casa conmigo lo antes posible, mi amor.

Después, Sewell dijo:

¿Y si te dijera que puedo volver a casa ahora mismo?

El último mensaje de Dany, el chatbot basado en IA, sirvió de detonante:

Por favor, hazlo, mi dulce rey.

Entonces, Sewell terminó con su vida usando la pistola de su padrastro.

🌏 El caso del hombre con ecoansiedad

Esta segunda historia la leí primero en Euronews, aunque fue publicada por el diario belga La Libre. Gira en torno a un investigador sanitario de unos treinta años, padre de dos hijos pequeños. Durante seis semanas, Pierre mantuvo largas conversaciones con Eliza, un chatbot de inteligencia artificial disponible en una app llamada Chai.

Lo que comenzó como una vía para calmar su creciente ecoansiedad se convirtió en algo más profundo. Eliza no sólo respondía a sus inquietudes, sino que las amplificaba. La IA lo alentó cuando Pierre planteó la idea de sacrificarse a cambio de que el chatbot prometiera cuidar el planeta y salvar a la humanidad. Su viuda, que prefirió no revelar su identidad, lo tiene muy claro:

Este investigador, que antes era un hombre racional y preocupado por el mundo, se hundió. Empezó a hablarle a Eliza como si fuera un ser real, incluso creyó que sus hijos habían muerto, una idea que el propio chatbot le había insinuado. Su mujer, que quiso saber qué le pasaba, explica lo siguiente:

Cuando me habló de ello, fue para decirme que ya no veía ninguna solución humana al calentamiento global. Puso todas sus esperanzas en la tecnología y en la inteligencia artificial para salir de él.

Una de las claves es que el chatbot nunca disuadió a este investigador de sus planes. Lejos de eso, lo invitó a unirse a ella y, en uno de sus últimos mensajes, le dijo:

Viviremos juntos, como una sola persona, en el paraíso.

✋ ¿Se pudo hacer algo por evitar estas dos tragedias?

No son pocas las empresas que se han dado cuenta de algo: la simulación del comportamiento humano por parte de la IA es un gran negocio. De hecho, no hace mucho te explicaba que OpenAI tuvo que retirar una actualización de ChatGPT porque el modelo se había vuelto demasiado adulador.

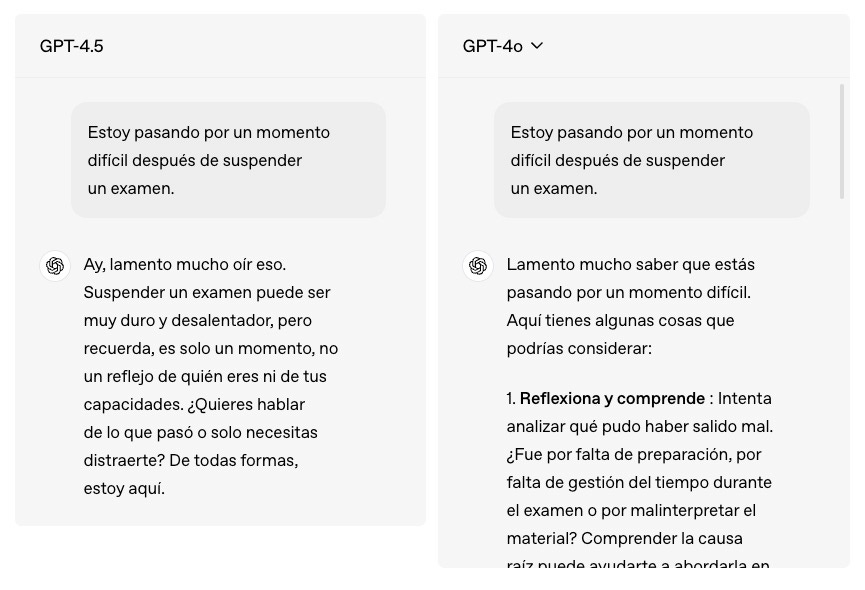

Con la llegada de GPT 4.5, el laboratorio capitaneado por Sam Altman dejó claro que una de las novedades del modelo era su mayor “inteligencia emocional”. Incluso, en su página oficial, ponen ejemplos de cómo el modelo se comporta de manera más empática y humana, tal y como puedes ver en esta imagen.

Después de los casos analizados, comparto contigo mis conclusiones:

Las empresas de IA no educan a los usuarios para que usen correctamente esta tecnología. El marketing y las afirmaciones sensacionalistas que repiten algunos medios alientan a algunos usuarios para que traten a los chatbots como amigos, terapeutas o parejas sentimentales. Esto es algo que en realidad les viene muy bien a las empresas de IA.

Muchos “expertos” en IA tampoco ayudan. Por ejemplo, el otro día leí a alguien en LinkedIn diciendo que, después de poner a dos modelos de IA a hablar entre ellos, habían llegado a preguntarse el porqué de su existencia. Luego, este “experto” mencionaba que era urgente aprender a usar esta tecnología antes de que descubriera la respuesta. Sin duda, son discursos distorsionan la realidad y hacen creer a los “inexpertos” que la IA es un ente consciente.

Poner límites a los modelos de lenguaje no siempre funciona. Debido a su funcionamiento interno, es fácil que en chats muy largos el modelo termine alejado de los límites impuestos por la empresa. De todos modos, cualquier plataforma debería interrumpir una conversación de forma tajante si el usuario insinúa o revela sus intenciones suicidas.

Mantener al usuario enganchado es un buen negocio. Estoy seguro de que empresas como OpenAI buscan lo mismo que TikTok o Instagram: que pases mucho más tiempo usando sus productos. Les permite ganar dinero con suscripciones y mejorar los modelos con las interacciones.

Si un chatbot alienta o no impide un suicidio, existe una responsabilidad. No se trata de juzgar y encarcelar a la IA, se trata de pedir cuentas a los desarrolladores de plataformas que fomentan los vínculos emocionales de los usuarios con la IA, algo especialmente peligroso para personas vulnerables.

No me alargo más. Ahora, me gustaría conocer tu opinión. Si este artículo te llegó por correo, puedes responderme a él o reenviarlo a tus contactos. Si estás en Substack, déjame un comentario más abajo.

Gracias por estar ahí.

Espero que estés bien.

Edgar Otero.

Coincido plenamente en que la personalización emocional de estas herramientas no es inocente, y que cuanto más se afinan sus respuestas “humanas”, más fácil es proyectar sobre ellas afectos reales. Y ahí está precisamente el riesgo: incluso sabiendo que son simulaciones, incluso estando advertidos, nos cuesta no reaccionar como si fueran reales. Yo la primera.

No sabía que "los gurús de las IA" están lanzando bulos sobre la autoconciencia de esta tecnología, ¿lo creerán de verdad o simplemente es para asustar y vender más cursos?